BTC/HKD+1.13%

BTC/HKD+1.13% ETH/HKD+1%

ETH/HKD+1% LTC/HKD+0.19%

LTC/HKD+0.19% ADA/HKD+0.21%

ADA/HKD+0.21% SOL/HKD+1.96%

SOL/HKD+1.96% XRP/HKD+0.04%

XRP/HKD+0.04%作者:阿法兔

整理了一下ChatGPT的發展歷程、背后的技術原理,以及它的局限性在哪。

ChatGPT是個啥?

ChatGPT是個啥?

近期,OpenAI發布了ChatGPT,是一個可以對話的方式進行交互的模型,因為它的智能化,得到了很多用戶的歡迎。ChatGPT也是OpenAI之前發布的InstructGPT的親戚,ChatGPT模型的訓練是使用RLHF也許ChatGPT的到來,也是OpenAI的GPT-4正式推出之前的序章。

什么是GPT?從GPT-1到GPT-3

GenerativePre-trainedTransformer(GPT),是一種基于互聯網可用數據訓練的文本生成深度學習模型。它用于問答、文本摘要生成、機器翻譯、分類、代碼生成和對話AI。

2018年,GPT-1誕生,這一年也是NLP的預訓練模型元年。性能方面,GPT-1有著一定的泛化能力,能夠用于和監督任務無關的NLP任務中。其常用任務包括:

自然語言推理:判斷兩個句子的關系

問答與常識推理:輸入文章及若干答案,輸出答案的準確率

語義相似度識別:判斷兩個句子語義是否相關

分類:判斷輸入文本是指定的哪個類別

雖然GPT-1在未經調試的任務上有一些效果,但其泛化能力遠低于經過微調的有監督任務,因此GPT-1只能算得上一個還算不錯的語言理解工具而非對話式AI。

Framework Ventures從GRT質押合約中提取9900萬個GRT代幣,價值約700萬美元:金色財經報道,CoinGecko和Messari的數據顯示,風投 Framework Ventures 從The Graph 的 GRT 質押合約中提取了 9900 萬個 GRT 代幣,價值約 700 萬美元,這是該地址有史以來規模最大的提幣,這些代幣隨后被發送至Coinbase。 GRT 代幣流通供應量也相應增加,目前約為 74 億。從質押合約中提取代幣可能意味著 Framework 可能會放棄未來的質押利潤,不確定 Framework 是否已經在 Coinbase 上出售了它的 GRT 代幣;截至發稿時,該基金未回復置評請求。

根據Nansen的說法,Framework Ventures 轉讓的 GRT 數量是至少在過去 12 個月中最大的 10 筆 GRT 交易之一。CryptoQuant 營銷主管 Hochan Chung 表示,這種規模的轉移“是巨大的,占流通量的 1%”。市場數據顯示,GRT 自 1 月 9 日轉賬以來一直徘徊在 7 美分左右,尚未出現重大下行趨勢。[2023/1/14 11:11:17]

GPT-2也于2019年如期而至,不過,GPT-2并沒有對原有的網絡進行過多的結構創新與設計,只使用了更多的網絡參數與更大的數據集:最大模型共計48層,參數量達15億,學習目標則使用無監督預訓練模型做有監督任務。在性能方面,除了理解能力外,GPT-2在生成方面第一次表現出了強大的天賦:閱讀摘要、聊天、續寫、編故事,甚至生成假新聞、釣魚郵件或在網上進行角色扮演通通不在話下。在“變得更大”之后,GPT-2的確展現出了普適而強大的能力,并在多個特定的語言建模任務上實現了彼時的最佳性能。

數據:一巨鯨從Gearbox移除1000萬枚USDC后存入Aave并借入1000枚ETH:金色財經報道,據PeckShield監測,czsb.eth地址從Gearbox USDC池中移除1000萬枚USDC流動性,之后存至AaveV2后借入1000枚ETH(約合127萬美元),并將這些ETH轉入幣安。[2022/12/13 21:41:44]

之后,GPT-3出現了,作為一個無監督模型,幾乎可以完成自然語言處理的絕大部分任務,例如面向問題的搜索、閱讀理解、語義推斷、機器翻譯、文章生成和自動問答等等。而且,該模型在諸多任務上表現卓越,例如在法語-英語和德語-英語機器翻譯任務上達到當前最佳水平,自動產生的文章幾乎讓人無法辨別出自人還是機器,更令人驚訝的是在兩位數的加減運算任務上達到幾乎100%的正確率,甚至還可以依據任務描述自動生成代碼。一個無監督模型功能多效果好,似乎讓人們看到了通用人工智能的希望,可能這就是GPT-3影響如此之大的主要原因

GPT-3模型到底是什么?

實際上,GPT-3就是一個簡單的統計語言模型。從機器學習的角度,語言模型是對詞語序列的概率分布的建模,即利用已經說過的片段作為條件預測下一個時刻不同詞語出現的概率分布。語言模型一方面可以衡量一個句子符合語言文法的程度,同時也可以用來預測生成新的句子。例如,對于一個片段“中午12點了,我們一起去餐廳”,語言模型可以預測“餐廳”后面可能出現的詞語。一般的語言模型會預測下一個詞語是“吃飯”,強大的語言模型能夠捕捉時間信息并且預測產生符合語境的詞語“吃午飯”。

通常,一個語言模型是否強大主要取決于兩點:首先看該模型是否能夠利用所有的歷史上下文信息,上述例子中如果無法捕捉“中午12點”這個遠距離的語義信息,語言模型幾乎無法預測下一個詞語“吃午飯”。其次,還要看是否有足夠豐富的歷史上下文可供模型學習,也就是說訓練語料是否足夠豐富。由于語言模型屬于自監督學習,優化目標是最大化所見文本的語言模型概率,因此任何文本無需標注即可作為訓練數據。

10000枚ETH從Gemini轉移至未知地址:8月25日消息,Tokenview數據顯示,8月25日09:43:20,10000枚ETH從Gemini轉入至地址0x645...fda9。[2022/8/25 12:47:06]

由于GPT-3更強的性能和明顯更多的參數,它包含了更多的主題文本,顯然優于前代的GPT-2。作為目前最大的密集型神經網絡,GPT-3能夠將網頁描述轉換為相應代碼、模仿人類敘事、創作定制詩歌、生成游戲劇本,甚至模仿已故的各位哲學家——預測生命的真諦。且GPT-3不需要微調,在處理語法難題方面,它只需要一些輸出類型的樣本。可以說GPT-3似乎已經滿足了我們對于語言專家的一切想象。

注:上文主要參考以下文章:

1.GPT4發布在即堪比人腦,多位圈內大佬坐不住了!-徐杰承、云昭-公眾號51CTO技術棧-2022-11-2418:08

2.一文解答你對GPT-3的好奇!GPT-3是什么?為何說它如此優秀?-張家俊中國科學院自動化研究所2020-11-1117:25發表于北京

3.TheBatch:329|InstructGPT,一種更友善、更溫和的語言模型-公眾號DeeplearningAI-2022-02-0712:30

GPT-3存在什么問題?

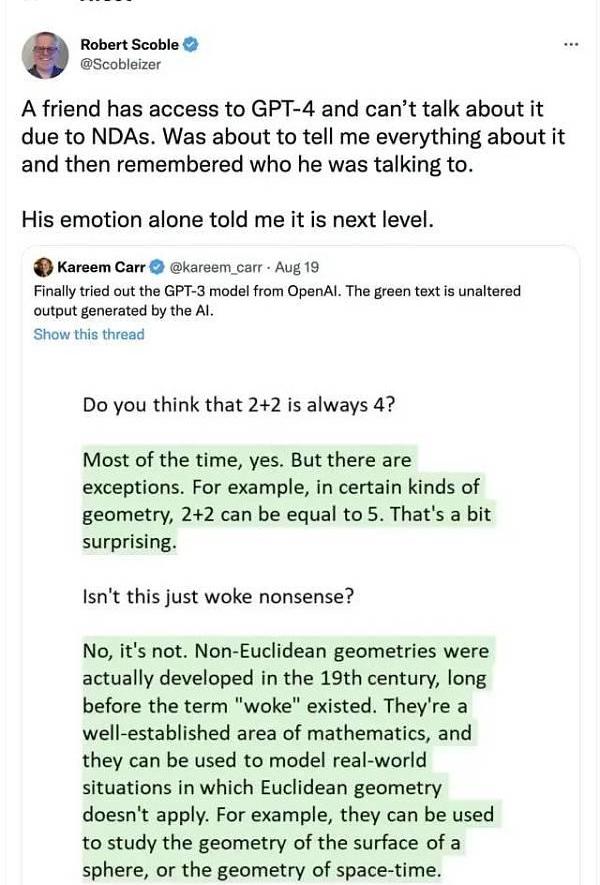

但是GTP-3并不完美,當前有人們最擔憂人工智能的主要問題之一,就是聊天機器人和文本生成工具等很可能會不分青紅皂白和質量好壞,地對網絡上的所有文本進行學習,進而生產出錯誤的、惡意冒犯的、甚至是攻擊性的語言輸出,這將會充分影響到它們的下一步應用。

數據:10615枚ETH從Gemini轉移至未知錢包:金色財經報道,據WhaleAlert數據顯示,10615枚ETH(價值17487756美元)從Gemini轉移至未知錢包。[2022/8/24 12:44:33]

OpenAI也曾經提出,會在不久的將來發布更為強大的GPT-4:

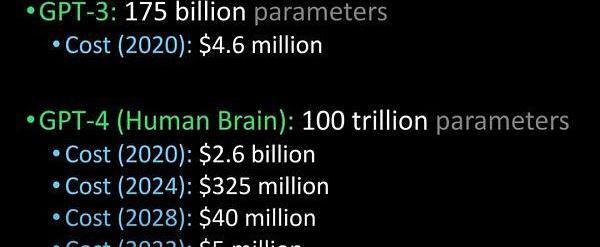

將?GPT-3與GPT-4、?人腦進行比較

據說,GPT-4會在明年發布,它能夠通過圖靈測試,并且能夠先進到和人類沒有區別,除此之外,企業引進GPT-4的成本也將大規模下降。

ChatGP與InstructGPT

ChatGPT與InstructGPT

談到Chatgpt,就要聊聊它的“前身”InstructGPT。

2022年初,OpenAI發布了InstructGPT;在這項研究中,相比GPT-3而言,OpenAI采用對齊研究,訓練出更真實、更無害,而且更好地遵循用戶意圖的語言模型InstructGPT,InstructGPT是一個經過微調的新版本GPT-3,可以將有害的、不真實的和有偏差的輸出最小化。

InstructGPT的工作原理是什么?

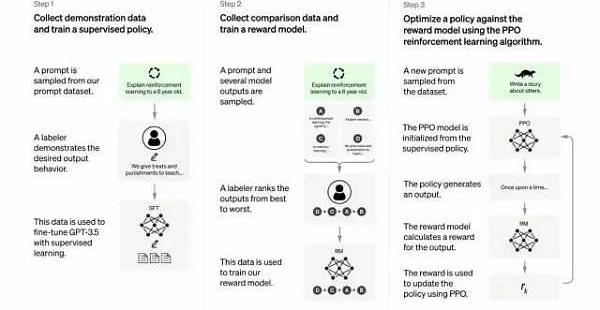

開發人員通過結合監督學習+從人類反饋中獲得的強化學習。來提高GPT-3的輸出質量。在這種學習中,人類對模型的潛在輸出進行排序;強化學習算法則對產生類似于高級輸出材料的模型進行獎勵。

Bitfinex首席技術官:比特幣將從GameStop事件中獲益:Bitfinex首席技術官Paolo Ardoino表示,GameStop (GME)等股票的突然上漲給比特幣(BTC)帶來了積極的影響,他稱,“GameStop事件只是對金融現狀的大規模反抗的開始,隨著GameStop問題成為焦點,比特幣將再次崛起。”(Cointelegraph)[2021/1/31 18:32:35]

訓練數據集以創建提示開始,其中一些提示是基于GPT-3用戶的輸入,比如“給我講一個關于青蛙的故事”或“用幾句話給一個6歲的孩子解釋一下登月”。

開發人員將提示分為三個部分,并以不同的方式為每個部分創建響應:

人類作家會對第一組提示做出響應。開發人員微調了一個經過訓練的GPT-3,將它變成InstructGPT以生成每個提示的現有響應。

下一步是訓練一個模型,使其對更好的響應做出更高的獎勵。對于第二組提示,經過優化的模型會生成多個響應。人工評分者會對每個回復進行排名。在給出一個提示和兩個響應后,一個獎勵模型(另一個預先訓練的GPT-3)學會了為評分高的響應計算更高的獎勵,為評分低的回答計算更低的獎勵。

開發人員使用第三組提示和強化學習方法近端策略優化(ProximalPolicyOptimization,PPO)進一步微調了語言模型。給出提示后,語言模型會生成響應,而獎勵模型會給予相應獎勵。PPO使用獎勵來更新語言模型。

本段參考:TheBatch:329|InstructGPT,一種更友善、更溫和的語言模型-公眾號DeeplearningAI-2022-02-0712:30

重要在何處?核心在于——人工智能需要是能夠負責任的人工智能

OpenAI的語言模型可以助力教育領域、虛擬治療師、寫作輔助工具、角色扮演游戲等,在這些領域,社會偏見、錯誤信息和害信息存在都是比較麻煩的,能夠避免這些缺陷的系統才能更具備有用性。

Chatgpt與InstructGPT的訓練過程有哪些不同?

總體來說,Chatgpt和上文的InstructGPT一樣,是使用RLHF訓練的。不同之處在于數據是如何設置用于訓練的。

ChatGPT存在哪些局限性?

如下:

a)在訓練的強化學習(RL)階段,沒有真相和問題標準答案的具體來源,來答復你的問題。

b)訓練模型更加謹慎,可能會拒絕回答。

c)監督訓練可能會誤導/偏向模型傾向于知道理想的答案,而不是模型生成一組隨機的響應并且只有人類評論者選擇好的/排名靠前的響應

注意:ChatGPT對措辭敏感。,有時模型最終對一個短語沒有反應,但對問題/短語稍作調整,它最終會正確回答。訓練者更傾向于喜歡更長的答案,因為這些答案可能看起來更全面,導致傾向于更為冗長的回答,以及模型中會過度使用某些短語,如果初始提示或問題含糊不清,則模型不會適當地要求澄清。

ChatGPT’sself-identifiedlimitationsareasfollows.

Plausible-soundingbutincorrectanswers:

a)ThereisnorealsourceoftruthtofixthisissueduringtheReinforcementLearning(RL)phaseoftraining.?

b)Trainingmodeltobemorecautiouscanmistakenlydeclinetoanswer(falsepositiveoftroublesomeprompts).

c)Supervisedtrainingmaymislead/biasthemodeltendstoknowtheidealanswerratherthanthemodelgeneratingarandomsetofresponsesandonlyhumanreviewersselectingagood/highly-rankedresponseChatGPTissensitivetophrasing.Sometimesthemodelendsupwithnoresponseforaphrase,butwithaslighttweaktothequestion/phrase,itendsupansweringitcorrectly.

Trainerspreferlongeranswersthatmightlookmorecomprehensive,leadingtoabiastowardsverboseresponsesandoveruseofcertainphrases.Themodelisnotappropriatelyaskingforclarificationiftheinitialpromptorquestionisambiguous.AsafetylayertorefuseinappropriaterequestsviaModerationAPIhasbeenimplemented.However,wecanstillexpectfalsenegativeandpositiveresponses.

參考文獻:

1.https://medium.com/inkwater-atlas/chatgpt-the-new-frontier-of-artificial-intelligence-9aee81287677

2.https://pub.towardsai.net/openai-debuts-chatgpt-50dd611278a4

3.https://openai.com/blog/chatgpt/

4.GPT4發布在即堪比人腦,多位圈內大佬坐不住了!-徐杰承、云昭-公眾號51CTO技術棧-2022-11-2418:08

5.一文解答你對GPT-3的好奇!GPT-3是什么?為何說它如此優秀?-張家俊中國科學院自動化研究所2020-11-1117:25發表于北京

6.TheBatch:329|InstructGPT,一種更友善、更溫和的語言模型-公眾號DeeplearningAI-2022-02-0712:30

三大CeFi平臺之二已破產清算,唯留手握20億美元資產規模的Nexo。FTX暴雷之后,烏云延伸到了多家平臺,Genesis、BlockFi等紛紛告急;Celsius,三大CeFI之一的已經在上一.

1900/1/1 0:00:00與SBT提供的單一定性數據點相比,聲譽的定量模型可能更有意義。本文主要探討在DAO網絡中,如何量化貢獻者聲譽。在下一篇文章中,我們將探討該量化模型框架對DAO治理的潛在影響.

1900/1/1 0:00:00來源:Bankless 編譯:比推BitpushNewsMaryLiuFTX的崩潰對整個加密貨幣市場造成了嚴重破壞,市場低迷,公司倒閉,并破壞了對該行業的信任.

1900/1/1 0:00:00社區文化是共同目標和集體能動性之間的連接樞紐。 社區與文化 沒有強大而積極的文化,就不可能擁有繁榮的社區.

1900/1/1 0:00:007:00-12:00關鍵詞:LINK質押、ArkInvest、MakerDAO、Genesis1.Chainlink:v0.1質押池將于12月9日開放.

1900/1/1 0:00:00原文來源于PhotonFinance,作者為DeFi開發公司Ekonomia?的CEO、PhotonFinance開發人員?DaveKajpust,白澤研究院編譯,略有刪改.

1900/1/1 0:00:00