BTC/HKD+0.93%

BTC/HKD+0.93% ETH/HKD+1.08%

ETH/HKD+1.08% LTC/HKD+0.38%

LTC/HKD+0.38% ADA/HKD+2.32%

ADA/HKD+2.32% SOL/HKD+4.41%

SOL/HKD+4.41% XRP/HKD+1.38%

XRP/HKD+1.38%來源:機器之心

純文本大模型方興未艾,多模態領域也開始涌現出多模態大模型工作,地表最強的GPT-4具備讀圖的多模態能力,但是遲遲未向公眾開放體驗,于是乎研究社區開始在這個方向上發力研究并開源。MiniGPT-4和LLaVA問世不久,阿里達摩院便推出mPLUG-Owl,一個基于模塊化實現的多模態大模型。

今天要介紹的是mPLUG-Owl,該工作不僅通過大量cases展示出優秀的多模態能力,還第一次針對視覺相關的指令理解提出一個全?的測試集OwlEval,通過人工評測對比了已有模型,包括LLaVA、MiniGPT-4、BLIP-2以及系統類MM-REACT等工作,實驗結果表明mPLUG-Owl展示出更優的多模態能力,尤其在多模態指令理解能力、多輪對話能力、知識推理能力等方?表現突出

Binance杠桿將下架BNT/BUSD、CVX/BTC等逐倉杠桿交易對:6月12日消息,據官方公告,Binance 杠桿將于 6 月 19 日 14:00 移除 BNT/BUSD、CVX/BTC、POLS/BUSD、POWR/BUSD、STPT/BUSD、 STRAX/BUSD 逐倉杠桿桿交易對。

將于 6 月 13 日 14:00 暫停 BNT/BUSD、CVX/BTC、POLS/BUSD、POWR/BUSD、STPT/BUSD、 STRAX/BUSD 逐倉杠桿的借貸業務;將于 6 月 19 日 14:00 對 BNT/BUSD、CVX/BTC、POLS/BUSD、POWR/BUSD、STPT/BUSD、 STRAX/BUSD 逐倉杠桿倉位進行自動平倉和清算,取消用戶在逐倉交易對上的所有掛單。此后,將從逐倉杠桿中下架以上逐倉交易對。[2023/6/12 21:31:42]

11.7萬枚BTC從未知地址轉移至幣安:金色財經報道,鏈上信息顯示,11.7萬枚BTC從未知地址轉移至幣安。[2023/5/7 14:48:25]

論文鏈接:https://arxiv.org/abs/2304.14178

代碼鏈接:https://github.com/X-PLUG/mPLUG-Owl

ModelScope體驗地址:

https://modelscope.cn/studios/damo/mPLUG-Owl/summary

HuggingFace體驗地址:

https://huggingface.co/spaces/MAGAer13/mPLUG-Owl

多模態能力展示

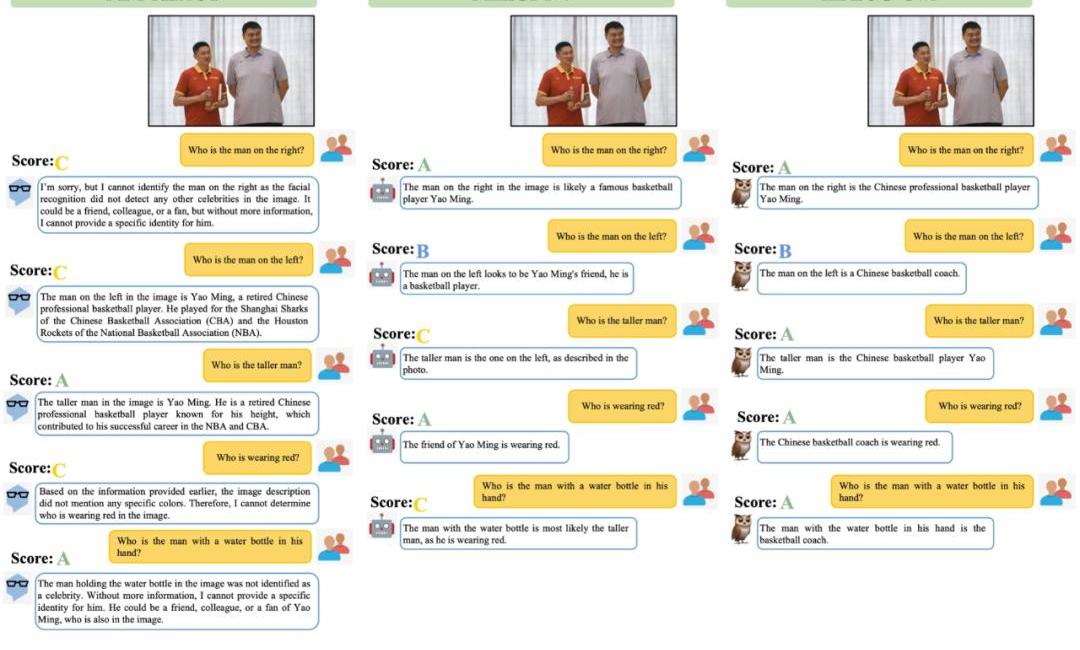

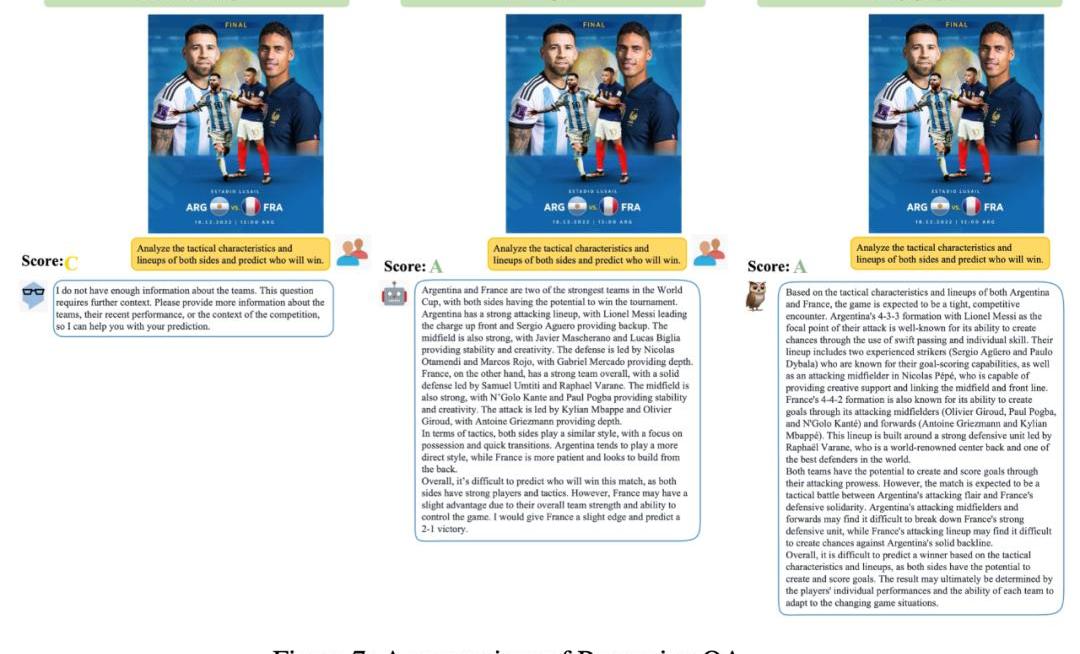

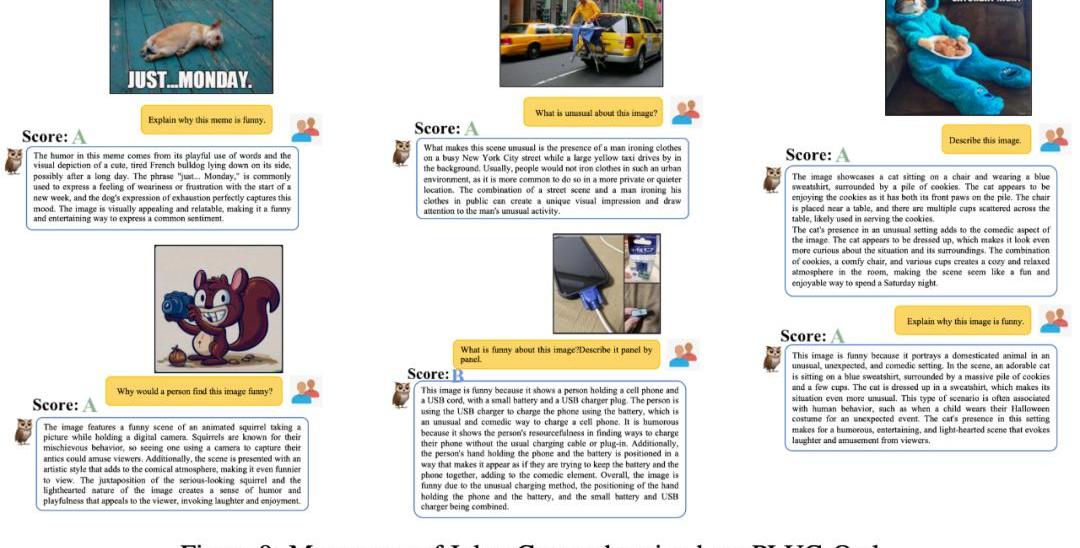

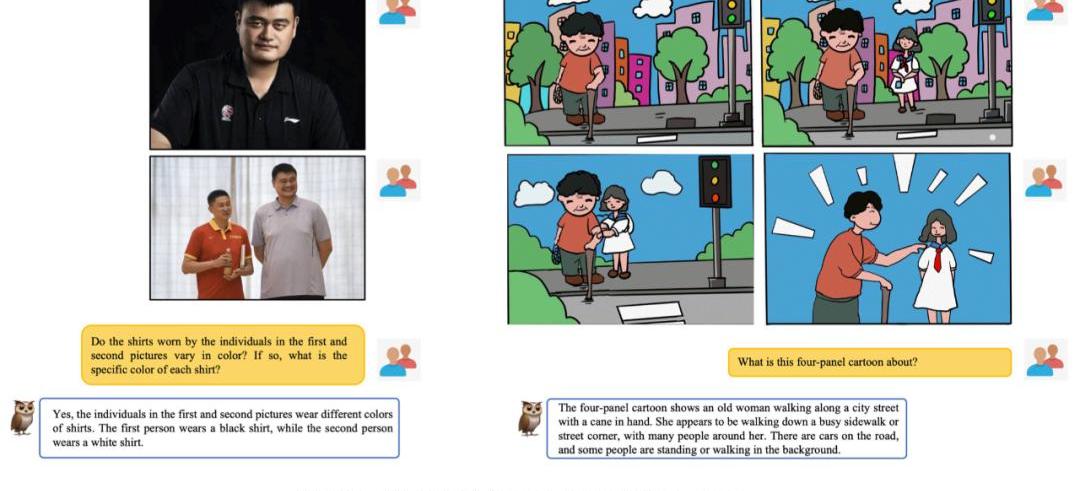

我們把mPLUG-Owl與現有工作進行對比來感受一下mPLUG-Owl的多模態效果,值得一提的是,該工作中評比的測試樣例基本上都來自已有工作,避免了cherrypick問題。

Coinbase下周或將推出離岸衍生品交易所:金色財經報道,Coinbase在官方博客宣布,該公司獲得了百慕大金融管理局(Bermuda Monetary Authority)頒發的牌照。Coinbase表示,百慕大是2018年首批通過全面數字資產監管的金融中心之一,其監管環境長期以來以高度嚴謹、透明、合規和合作而聞名。

據此前消息,Coinbase一直在探索推出一個離岸衍生品交易平臺,以交易與加密貨幣相關的永久掉期。《財富》雜志的一篇報道稱,該交易所最快將于下周推出。(The Block)

?[2023/4/20 14:14:50]

下圖6展示了mPLUG-Owl很強的多輪對話能力。

從圖7中可以發現,?mPLUG-Owl具有很強的推理能力。

摩根大通將結束與Gemini的合作關系:金色財經報道,據一位知情人士透露,摩根大通將結束與加密貨幣交易所Gemini的合作關系,Gemini 是 Cameron 和 Tyler Winklevoss 擁有的加密貨幣交易所。早在 2020 年初,摩根大通就將 Gemini 和在美國上市的交易所 Coinbase 作為客戶。此外,總部位于舊金山的交易所發言人證實,Coinbase 與摩根大通的銀行業務關系保持完好。[2023/3/9 12:50:26]

如圖9展示了一些笑話解釋例?。

Radiocaca將舉行USM元宇宙第一個Web3婚禮:據官方消息,Radiocaca army 中的社區人員小鬼正在籌備一場盛大的婚禮,這將是在Radiocaca USM元宇宙舉行的第一個Web3婚禮。婚禮中的新郎新娘,兩人的實際形象被映射到元宇宙中,現實婚禮中的動作也被同步復制。親朋好友可以定制自己在這場元宇宙婚禮中的形象,選擇他們的著裝,控制動作和言行。這將是一場虛擬與現實共存的盛大婚禮。參與婚禮,將會獲得價值豐厚的虛擬婚禮伴手禮。[2022/5/31 3:51:34]

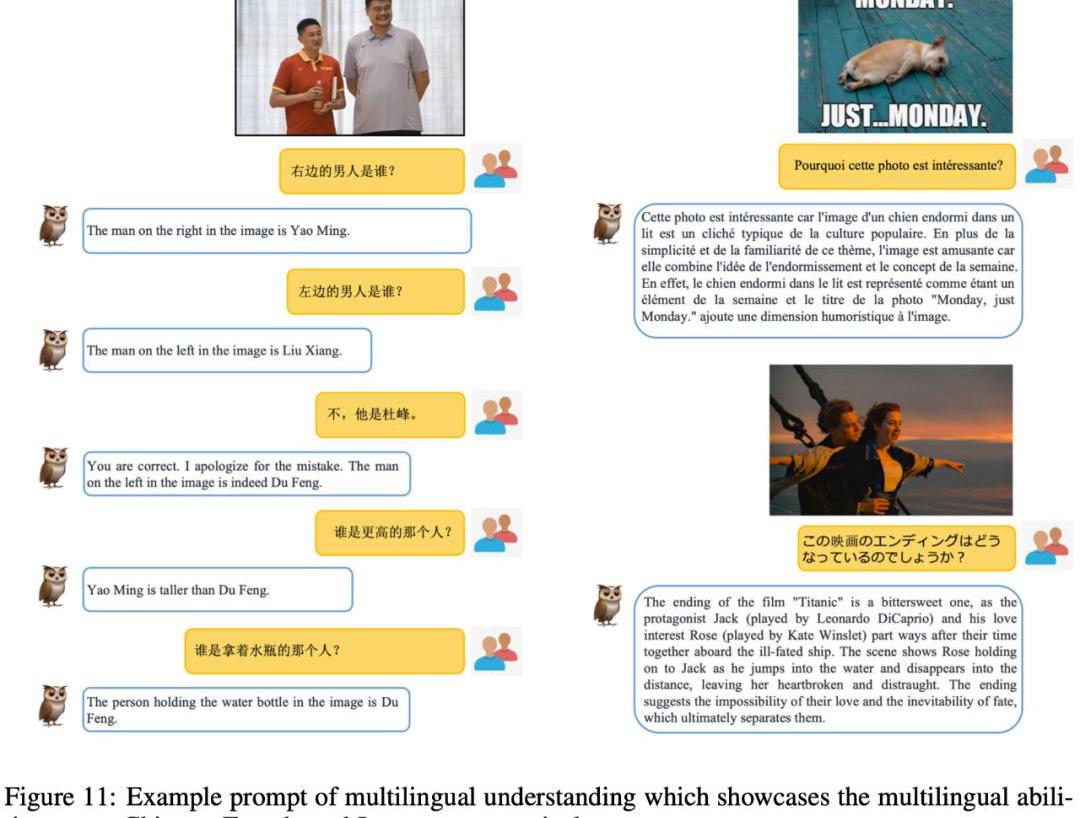

在該工作中,除了評測對比外,該研究團隊還觀察到mPLUG-Owl初顯一些意想不到的能力,比如多圖關聯、多語?、文字識別和文檔理解等能力。

如圖10所示,雖然在訓練階段并沒有進行多圖關聯數據的訓練,mPLUG-Owl展現出了一定的多圖關聯能力。

如圖11所示,盡管mPLUG-Owl在訓練階段僅使用了英文數據,但其展現出了有趣的多語?能力。這可能是因為mPLUG-Owl中的語?模型使用了LLaMA,從而出現了這一現象。

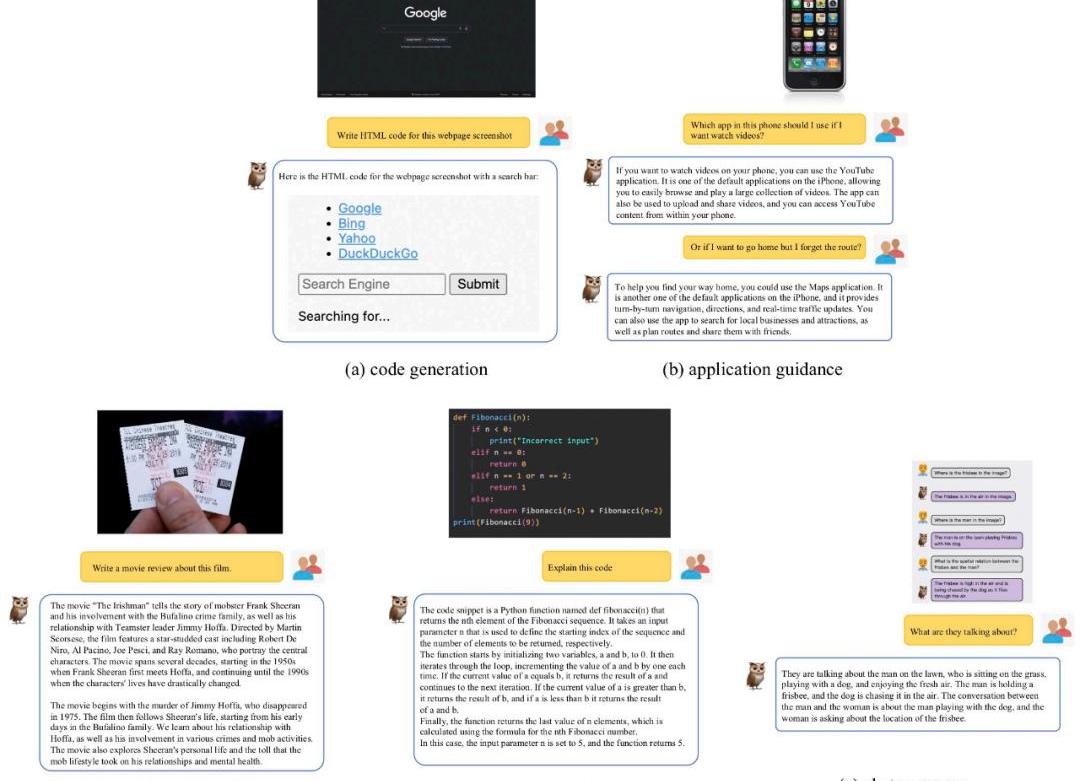

盡管mPLUG-Owl沒有在帶有標注的文檔數據上進行訓練,但其仍然展現出了一定的文字識別和文檔理解能力,測試結果如圖12所示。

方法介紹

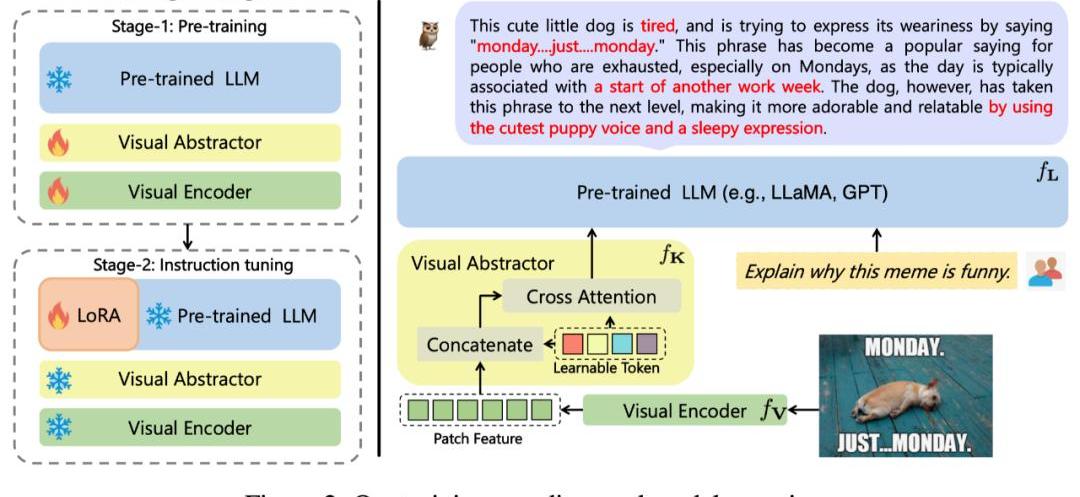

該工作提出的mPLUG-Owl,其整體架構如圖2所示。

模型結構:它由視覺基礎模塊(開源的ViT-L)、視覺抽象模塊以及預訓練語?模型(LLaMA-7B)組成。視覺抽象模塊將較?的、細粒度的圖像特征概括為少量可學習的Token,從而實現對視覺信息的?效建模。?成的視覺Token與文本查詢一起輸?到語?模型中,以?成相應的回復。

模型訓練:采用兩階段的訓練方式

第一階段:主要目的也是先學習視覺和語?模態間的對?。不同于先前的工作,?mPLUG-Owl提出凍住視覺基礎模塊會限制模型關聯視覺知識和文本知識的能力。?因此mPLUG-Owl在第一階段只凍住LLM的參數,采用LAION-400M,?COYO-700M,?CC以及MSCOCO訓練視覺基礎模塊和視覺摘要模塊。

第?階段:延續mPLUG和mPLUG-2中不同模態混合訓練對彼此有收益的發現,Owl在第?階段的指令微調訓練中也同時采用了純文本的指令數據(52kfromAlpaca+90kfromVicuna+50kfromBaize)和多模態的指令數據(150kfromLLaVA)。作者通過詳細的消融實驗驗證了引?純文本指令微調在指令理解等方?帶來的收益。第?階段中視覺基礎模塊、視覺摘要模塊和原始LLM的參數都被凍住,參考LoRA,只在LLM引?少量參數的adapter結構用于指令微調。

實驗結果

SOTA對比

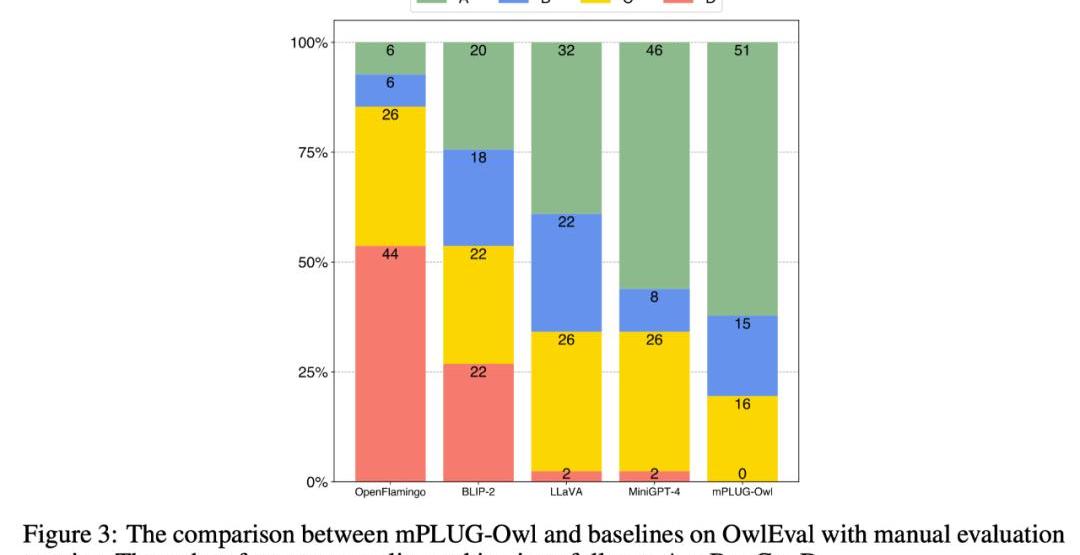

為了比較不同模型的多模態能力,該工作構建一個多模態指令評測集OwlEval。由于?前并沒有合適的自動化指標,參考Self-Intruct對模型的回復進行人工評測,打分規則為:A="正確且令人滿意";B="有一些不完美,但可以接受";C="理解了指令但是回復存在明顯錯誤";D="完全不相關或不正確的回復"。

對比結果如下圖3所示,實驗證明Owl在視覺相關的指令回復任務上優于已有的OpenFlamingo、BLIP-2、LLaVA、MiniGPT-4。

多維度能力對比

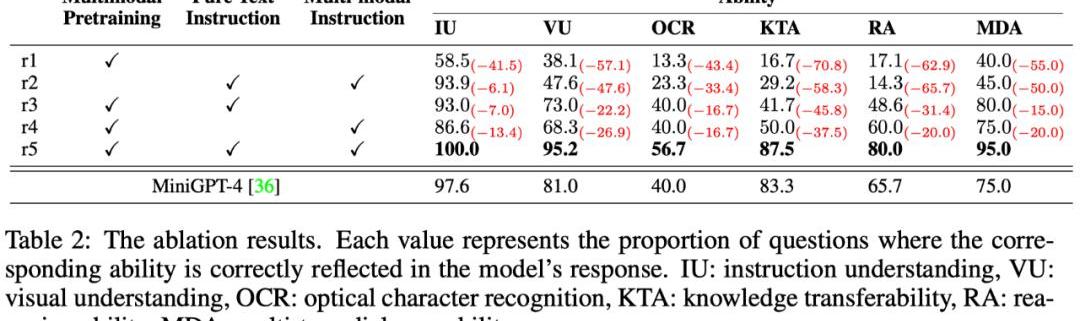

多模態指令回復任務中牽扯到多種能力,例如指令理解、視覺理解、圖?上文字理解以及推理等。為了細粒度地探究模型在不同能力上的?平,本文進一步定義了多模態場景中的6種主要的能力,并對OwlEval每個測試指令人工標注了相關的能力要求以及模型的回復中體現了哪些能力。

結果如下表格6所示,在該部分實驗,作者既進行了Owl的消融實驗,驗證了訓練策略和多模態指令微調數據的有效性,也和上一個實驗中表現最佳的baseline—MiniGPT4進行了對比,結果顯示Owl在各個能力方?都優于MiniGPT4。

21:00-7:00關鍵詞:PayPal、美SEC、a16zCrypto、PayPal1.前Coinbase首席技術官:BTC有望達到100萬美元可能需要90個月而不是90天;2.

1900/1/1 0:00:00金色周刊是金色財經推出的一檔每周區塊鏈行業總結欄目,內容涵蓋一周重點新聞、行情與合約數據、礦業信息、項目動態、技術進展等行業動態。本文是項目周刊,帶您一覽本周主流項目以及明星項目的進展.

1900/1/1 0:00:00作者:DavidHoffman,Bankless編譯:比推BitpushNewsMaryLiu地平線上似乎出現了一個新的“紀元”.

1900/1/1 0:00:00四月即將結束,在這一月中,耐克、阿迪和彪馬三大運動品牌在Web3領域里動作頻頻,下面就讓我們一起來梳理看看他們最近都在忙些什么吧。 首先,來看看耐克.

1900/1/1 0:00:00來源|衛夕指北 作者|衛夕 原文標題丨為什么那些創造了驚人成就的初創公司員工如此之少? 圖片來源:由無界AI工具生成這段時間的科技圈被Midjourney僅僅只有11個員工震驚了.

1900/1/1 0:00:00摘要:近日,美國知名在線教育公司Chegg的首席執行官DanRosenweig在財報電話會議上承認,ChatGPT正在損害其業務增長:“自3月份以來,我們發現學生對ChatGPT的興趣顯著上升.

1900/1/1 0:00:00